Czy informacja naprawdę ma swoją wagę?

Czy sms waży mniej niż film HD? Czy skasowanie plików z dysku sprawia, że komputer jest choć odrobinę lżejszy? Pytanie „ile waży informacja?” brzmi jak żart z pogranicza fizyki i filozofii, ale ma bardzo konkretne, matematyczne i praktyczne znaczenie. Żyjemy w epoce, w której niemal wszystko – od zdjęć po kontrakty handlowe – staje się sekwencją bitów. Zrozumienie, czym jest informacja i jak „przekłada się” na rzeczywistość, pomaga nie tylko w ogarnięciu technologii, ale też w podejmowaniu świadomych decyzji: jakie dane przechowywać, jak je zabezpieczać i ile one naprawdę „kosztują”.

Matematyka bitów wydaje się abstrakcyjna, ale działa w tle każdego kliknięcia na smartfonie. Każdy odtwarzany utwór, każde zdjęcie w chmurze i każda wiadomość e-mail to konkretny pakiet informacji, który zajmuje miejsce, wymaga energii i – w sensie fizycznym – ma swoją mikroskopijną wagę. Zrozumienie tej ukrytej warstwy cyfrowego świata pozwala inaczej spojrzeć na pojęcia „pojemności”, „przepustowości” czy „bezpieczeństwa danych”.

Żeby dojść do odpowiedzi na prowokujące pytanie o wagę informacji, trzeba zacząć od podstaw: czym jest bit, jak mierzy się ilość informacji i skąd wiadomo, że jedna wiadomość zawiera jej więcej niż inna. Dopiero potem da się przejść do bardziej zaskakujących wniosków: że każdy zapis na dysku twardym minimalnie zmienia jego masę, że wyczyszczenie pamięci flash wiąże się z dysypacją energii, a nawet, że istnieje coś takiego jak granica fizycznej „ceny” usunięcia bitu.

Bit, bajt i logarytm: matematyczne podstawy informacji

Czym jest bit – najprostsza jednostka informacji

Bit to skrót od binary digit – binarna cyfra. Może przyjąć jedną z dwóch wartości: 0 lub 1. Matematycznie to wszystko, ale ta prostota ma ogromną moc. Każdy tekst, zdjęcie czy film da się rozłożyć na bardzo długą sekwencję zer i jedynek. W elettronice odpowiadają im np. dwa poziomy napięcia, w pamięciach optycznych – obecność lub brak „dołka” na płycie.

Z punktu widzenia teorii informacji, bit oznacza odpowiedź na pytanie: „tak czy nie?”, „0 czy 1?”, „lewo czy prawo?”. Jeśli przed poznaniem odpowiedzi obie możliwości są równie prawdopodobne, pojedyncza odpowiedź niesie dokładnie jeden bit informacji. Przykład z życia: rzut symetryczną monetą. Nie wiemy, czy wypadnie orzeł, czy reszka – oba wyniki mają takie samo prawdopodobieństwo. Poznanie wyniku (o ile był uczciwy i losowy) dostarcza nam 1 bit informacji.

Gdy układ może przyjąć więcej stanów, np. 4 różne, pojedyncze rozróżnienie między nimi wymaga większej liczby bitów. Da się to odwzorować, zadając kolejne pytania „tak/nie”, które krok po kroku zawężają możliwości. To prowadzi do naturalnej roli logarytmu przy mierzeniu ilości informacji.

Logarytm dwójkowy i definicja ilości informacji

Claude Shannon, twórca teorii informacji, zaproponował matematyczną definicję ilości informacji. Jeśli istnieje zbiór możliwych stanów (np. możliwe znaki, wiadomości, wyniki doświadczeń), a każdy z nich ma określone prawdopodobieństwo wystąpienia, to ilość informacji związana z pojedynczym wynikiem opisuje się wzorem:

I = −log₂(p)

gdzie p to prawdopodobieństwo konkretnego wyniku. Im rzadsze (mniej prawdopodobne) zdarzenie, tym większą informację niesie fakt, że nastąpiło. Logarytm dwójkowy sprawia, że jednostką jest właśnie bit.

Prosty przykład:

- Rzut uczciwą monetą: p = 1/2, więc I = −log₂(1/2) = 1 bit.

- Rzut uczciwą kostką: p = 1/6, więc I = −log₂(1/6) ≈ 2,585 bitów na konkretny wynik (np. „wypadła 4”).

Jeśli mamy N możliwych, jednakowo prawdopodobnych wyników, ilość informacji z jednego rozstrzygnięcia wynosi log₂(N) bitów. Właśnie dlatego:

- 4 możliwe wyniki → log₂(4) = 2 bity (np. dwie kolejne odpowiedzi „tak/nie”),

- 256 możliwych wyników → log₂(256) = 8 bitów (np. jeden bajt może kodować 256 różnych znaków).

Od bitu do bajtu i dalej – jak rośnie skala

Praktyka komputerowa posługuje się większymi jednostkami, bo pojedynczy bit jest zbyt drobny. Podstawowe przeliczenia wyglądają tak:

| Jednostka | Symbol | Liczba bitów | Typowe zastosowanie |

|---|---|---|---|

| bit | b | 1 | najprostsza jednostka, poziom teoretyczny |

| bajt | B | 8 | pojedynczy znak, minimalna jednostka adresowana przez pamięć |

| kilobajt | KB | ok. 8 000 | małe pliki tekstowe, ustawienia |

| megabajt | MB | ok. 8 mln | zdjęcia, krótkie nagrania audio |

| gigabajt | GB | ok. 8 mld | filmy, aplikacje, pamięć RAM |

| terabajt | TB | ok. 8 bln | dyski do kopii zapasowych, serwery |

Uwaga na oznaczenia: małe „b” oznacza bity, duże „B” – bajty. Internetowe łącza reklamuje się najczęściej w megabitach na sekundę (Mb/s), a pojemność dysków w gigabajtach (GB). Różnica między Mb a MB to czynnik 8.

Matematyka bitów jest logarytmiczna: każdy dodatkowy bit podwaja liczbę możliwych stanów. 10 bitów → 1024 stany, 20 bitów → ponad milion, 30 bitów → ponad miliard. Dzięki temu nawet skomplikowane obiekty można odwzorować niebywale precyzyjnie, jeśli dysponuje się odpowiednią liczbą bitów – kosztem miejsca i energii potrzebnej na ich zapis.

Co to znaczy „ile waży informacja” – ujęcie fizyczne i cyfrowe

Informacja a nośnik: dane same z siebie nie „płyną w próżni”

Informacja jest abstrakcyjnym pojęciem. Kod „01000001” oznacza literę „A” w jednym standardzie, ale w innym może oznaczać coś zupełnie innego. Aby ta informacja istniała fizycznie, musi być zapisana na nośniku: w postaci ładunków elektrycznych, orientacji magnetycznej, stanu atomów czy fotonów. Bez fizycznego nośnika mówienie o „wadze informacji” nie ma sensu.

Gdy pyta się, ile waży sms, faktycznie pyta się: o ile zmienia się masa nośnika (np. układów pamięci w telefonie) przy zapisaniu lub usunięciu tej wiadomości, oraz jaka energia jest zużywana na tę operację. W skali codziennej masa się niemal nie zmienia, ale fizycznie – zmiana stanu milionów elementarnych nośników informacji musi mieć choćby śladowy wpływ na energię, a więc i efektywnie na masę.

W sensie makroskopowym bardziej użyteczna jest metaforyczna „waga” informacji: ile zajmuje miejsca na dysku, jaki ma koszt energetyczny i ekonomiczny, jak trudna jest do przesłania przez łącze o danej przepustowości. Z punktu widzenia użytkownika to właśnie ta „cyfrowa” waga jest kluczowa, choć u podstaw zawsze stoi fizyka.

Granica Landauera: minimalny koszt usunięcia bitu

Rolf Landauer w latach 60. sformułował zasadę, która łączy informację z termodynamiką. Głosi ona, że usunięcie jednego bitu informacji (np. z 0 lub 1 robimy „nie wiadomo co” i resetujemy układ) musi nieuchronnie wiązać się z wydzieleniem ciepła co najmniej:

kT ln 2

na bit, gdzie k to stała Boltzmanna, a T – temperatura w kelwinach. Oznacza to, że informacja nie jest „za darmo” w sensie fizycznym: jej kasowanie ma nieunikniony koszt energetyczny. W praktyce wszystkie obecne urządzenia są o wiele mniej wydajne niż ta teoretyczna granica, ale to ona wyznacza absolutne minimum.

Jak łączy się to z wagą? Einsteinowska relacja E = mc² mówi, że energia odpowiada masie. Skoro usunięcie bitu wymaga minimalnej energii, to zapisanie i przechowywanie informacji można powiązać z pewną – ekstremalnie małą – zmianą równoważnej masy. Współczesne przyrządy nie zarejestrują różnicy po skasowaniu sms-ów, lecz w zasadzie fizycznej nie ma tu żadnej „magii”: informacja ma swój energetyczny ślad.

Waga informacji w skali urządzeń cyfrowych

Pojedynczy bit to nieistotny ubytek masy, ale miliardy miliardów bitów na ogromnych serwerowniach już mogą mieć zauważalne przełożenie na zużycie energii i generowanie ciepła. Stąd ogromne zainteresowanie efektywnymi algorytmami, kompresją danych i optymalizacją kodu – mniej informacji do przechowania to mniejsze zapotrzebowanie na sprzęt, energię i chłodzenie.

Jeśli spojrzy się na informacje przechowywane w globalnej sieci jako na całość, ich „waga” energetyczna jest ogromna. Dane trzeba nie tylko przechować, lecz także wielokrotnie kopiować, przesyłać, synchronizować i zabezpieczać kopią zapasową. Każdy przedłużony czas przechowywania niepotrzebnych plików oznacza dodatkowe miliardy zapisanych i podtrzymywanych w stanie stabilnym bitów.

Z praktycznej perspektywy warto więc pytać nie tylko „ile miejsca zajmą te dane na dysku”, ale także: ile energii będzie kosztowało ich utrzymanie przez rok, pięć czy dziesięć lat oraz jak wpływa to na ogólny ślad środowiskowy infrastruktury cyfrowej.

Matematyka bitów w codziennym użytkowaniu technologii

Ile bitów ma Twoje zdjęcie i co z tego wynika

Zdjęcie wykonane współczesnym smartfonem ma zwykle rozdzielczość rzędu kilkunastu megapikseli. Przy 12 megapikselach otrzymuje się 12 milionów punktów obrazu. Dla uproszczenia przyjmijmy, że każdy piksel jest zapisywany w 24 bitach (8 bitów na kanał: czerwony, zielony, niebieski). Całkowita liczba bitów wynosi wtedy:

- 12 000 000 pikseli × 24 bity = 288 000 000 bitów,

- co daje 36 000 000 bajtów, czyli ok. 36 MB surowych danych.

Na szczęście formaty takie jak JPEG wykorzystują kompresję, która drastycznie zmniejsza tę liczbę, usuwając część informacji (kompresja stratna). W praktyce takie zdjęcie zajmie od kilkuset kilobajtów do kilku megabajtów, w zależności od ustawionego stopnia kompresji. Matematycznie zapis jest prosty: mniej bitów = mniej informacji, ale też potencjalnie niższa jakość obrazu.

Świadome ustawienie parametrów aparatu, formatu zapisu i stopnia kompresji oznacza realne zarządzanie ilością informacji: ile „ważnych” bitów jest przechowywanych, a ile można odrzucić, zachowując jeszcze akceptowalny efekt wizualny. To właśnie praktyczna gra między matematyczną ilością bitów a ludzkim odbiorem jakości.

Filmy, muzyka i streaming – bity w ruchu

Filmy i muzyka to przepływy informacji w czasie. Ich „waga” zależy nie tylko od jakości przestrzennej (rozdzielczość obrazu, liczba kanałów audio), ale też od czasu trwania.

Weźmy wideo Full HD (1920×1080 pikseli) przy 25 klatkach na sekundę. Pojedyncza klatka ma ok. 2,07 megapiksela. Nieskompresowany obraz RGB 24-bit:

- 2,07 mln pikseli × 24 bity ≈ 49,7 mln bitów na klatkę,

- 25 klatek na sekundę → ok. 1,24 mld bitów na sekundę ≈ 155 MB/s.

Taki strumień jest niepraktyczny, dlatego stosuje się zaawansowane kodeki (H.264, H.265, AV1), które wykorzystują zależności między kolejnymi klatkami i wewnątrz nich. Realny bitrate filmu Full HD na serwisie streamingowym wynosi np. kilka megabitów na sekundę – tysiące razy mniej niż surowe dane, a widz zauważa jedynie sporadyczne artefakty w trudnych scenach.

Podobnie jest z muzyką: nieskompresowany plik WAV lub FLAC 16 bit / 44,1 kHz stereo ma bitrate około 1,4 Mb/s. Popularny format MP3 przy bitrate 128–320 kb/s usuwa część informacji, którą ludzkie ucho w typowych warunkach i tak słabo rejestruje. To także matematyka bitów w praktyce: redukcja informacji z poszanowaniem percepcji człowieka.

Przepustowość łącza: ile bitów może „przepłynąć” w sekundę

Prędkość internetu opisuje się najczęściej w megabitach na sekundę (Mb/s). To dokładnie liczba bitów, które mogą zostać przesłane w ciągu jednej sekundy przez dane łącze. Jeśli operator oferuje 100 Mb/s, oznacza to teoretycznie 100 milionów bitów na sekundę.

Aby przełożyć to na czas pobierania plików, trzeba przejść z bitów na bajty:

- 100 Mb/s ÷ 8 = 12,5 MB/s (megabajta na sekundę),

- plik 1 GB (ok. 1000 MB) pobierze się w idealnych warunkach w ok. 80 sekund.

W praktyce zawsze występują narzuty protokołów, opóźnienia i współdzielenie łącza między urządzeniami, więc realne prędkości są niższe. Mimo to intuicja „ile bitów na sekundę” pozwala szybko oszacować, czy dane łącze wystarczy do oglądania filmu 4K, wideokonferencji czy wysłania backupu w chmurę.

Streaming usług wideo czy gier w chmurze polega na stałym dostarczaniu strumienia bitów z serwera do odbiorcy. Jeśli bitrate filmu wynosi 10 Mb/s, a łącze ma 20 Mb/s, pozostaje zapas na inne usługi. Gdyby łącze było wolniejsze od bitrate’u, bufor wideo szybko by się wyczerpał i obraz zaczynałby się zacinać – zwyczajnie zbyt mało bitów na sekundę dociera do urządzenia.

SMS, e‑mail i komunikatory: mikrogramy informacji w praktyce

Krótka wiadomość tekstowa jest dobrym polem do przećwiczenia rachunku bitów. Klasyczny SMS ma limit 160 znaków w kodowaniu GSM 7‑bit. Jeden znak to 7 bitów, więc cały SMS to:

- 160 × 7 = 1120 bitów,

- czyli 140 bajtów (1120 ÷ 8).

Do tego dochodzą nagłówki, informacje o nadawcy, numerze, czasie wysłania – nadal jednak całość mieści się w kilkuset bajtach. Z fizycznego punktu widzenia zapisanie takiej ilości danych w pamięci telefonu zmienia energię nośnika w skali kompletnie nieuchwytnej dla wagi kuchennej. W cyfrowym świecie 140 bajtów to niemal nic, ale codziennie wysyłane są miliardy takich wiadomości, a każdy bit przechodzi przez sieć stacji bazowych, serwerów i systemów billingowych.

W tygodniowym raporcie z aktywności poczta e‑mail może policzyć łączną „masę” korespondencji: np. 300 MB wysłanych i odebranych maili. Pojedyncza wiadomość tekstowa waży kilka kilobajtów, lecz gdy dołączone są zdjęcia, prezentacje czy dokumenty PDF, szybko robi się z tego wiele megabajtów. Z punktu widzenia serwera pocztowego to liczba bitów do zapisania na macierzy dyskowej, zbackupowania i wielokrotnego odczytania przez różne urządzenia użytkownika.

Kompresja danych: jak „odchudza się” informacje

Kompresja to bezpośrednia operacja na matematyce bitów. Celem jest zapisanie tej samej (lub prawie tej samej) informacji przy użyciu mniejszej liczby bitów.

Przy kompresji bezstratnej (ZIP, PNG, FLAC) dane po zdekompresowaniu są identyczne bit po bicie z oryginałem. Wykorzystuje się regularności w danych: powtarzające się ciągi znaków, przewidywalną strukturę plików tekstowych czy redundancję w zapisie liczb. Algorytmy takie jak Huffman czy LZ77 przypisują krótsze kody częściej występującym symbolom, dzięki czemu średnia liczba bitów na symbol spada.

Przykładowo, długi plik tekstowy z powtarzającymi się frazami może po kompresji zająć 20–30% pierwotnego rozmiaru. Liczba bitów w pliku maleje, ale ilość informacji rozumiana w sensie semantycznym pozostaje ta sama – nadal można przeczytać ten sam tekst. Zmienia się jedynie sposób kodowania na niższym poziomie.

Kompresja stratna (JPEG, MP3, H.264) idzie dalej: świadomie wyrzuca się część bitów, a więc część informacji. Robi się to jednak selektywnie, na podstawie modeli ludzkiej percepcji. Algorytm obrazu osłabia lub usuwa szczegóły, których oko zwykle nie odróżnia; kodek audio maskuje dźwięki we fragmentach, gdzie i tak dominują inne częstotliwości. W efekcie:

- duże zdjęcie RAW może mieć 25 MB, a jego wersja JPEG – 3 MB,

- utwór muzyczny w WAV może mieć 50 MB, a w MP3 5 MB.

Za każdą taką „dietą” stoi konkretny bilans bitów: mniej informacji do przechowywania i transferu, kosztem potencjalnie gorszej jakości w trudnych warunkach (duże powiększenie zdjęcia, wysokiej klasy sprzęt audio).

Redundancja i kopie zapasowe: celowe „dociążanie” informacji

Z drugiej strony infrastruktura cyfrowa celowo zwiększa ilość bitów reprezentujących tę samą treść, aby podnieść bezpieczeństwo. Pojedynczy plik może zostać zapisany:

- na kilku dyskach w jednym serwerze (RAID),

- w wielu centrach danych w różnych regionach geograficznych,

- w kilku wersjach historycznych (snapshoty, wersjonowanie).

Jeden gigabajt dokumentów użytkownika w chmurze może faktycznie oznaczać wielokrotnie większą liczbę gigabajtów na fizycznych macierzach. Matematyczna liczba bitów rośnie, lecz nie niesie nowej treści – to nadmiar służący do korekcji błędów i ochrony przed awariami.

Redundancja występuje także na niższym poziomie: pamięci RAM czy nośniki SSD używają kodów korekcyjnych (ECC), które dodają dodatkowe bity kontrolne. Dzięki nim możliwe jest wykrycie, a czasem naprawienie pojedynczych błędów. Z perspektywy inżyniera systemów jest to kompromis: więcej bitów na każdy „użyteczny” bit danych w zamian za wyższą niezawodność całości.

Szyfrowanie i hasła: ile bitów ma bezpieczeństwo

Bezpieczeństwo kryptograficzne opisuje się również w bitach. Mówi się np., że algorytm oferuje 128 czy 256 bitów bezpieczeństwa. Oznacza to, że atakujący musiałby w skrajnym przypadku przetestować 2128 lub 2256 możliwych kluczy – liczby astronomiczne.

Hasło użytkownika ma także swoją „entropię” mierzoną w bitach. Proste hasło złożone z kilku małych liter może mieć raptem kilkanaście bitów entropii, bo przestrzeń możliwych kombinacji jest niewielka. Złożona passphrase z kilkoma losowymi słowami, cyframi i znakami specjalnymi może dochodzić do 60–80 bitów entropii, co czyni atak metodą brute force praktycznie niewykonalnym przy obecnych zasobach obliczeniowych.

Tu matematyka bitów przekłada się bezpośrednio na realny poziom ochrony. Dodatkowe bity w kluczu szyfrującym czy w haśle nie zwiększają „objętości” wiadomości znacząco, a dramatycznie podnoszą koszt jej złamania. To powód, dla którego współczesne standardy jak AES‑256 są uważane za bezpieczne: liczba możliwych kluczy jest tak ogromna, że nawet superkomputery nie są w stanie ich przeszukać w rozsądnym czasie.

Informacja w mózgu: bity a neurony

Ludzki mózg nie posługuje się bitami w tak prosty sposób jak komputery, ale można przybliżać ilość informacji, jaką jest w stanie przechowywać, używając podobnych pojęć. Szacunki mówią o rzędu 1014–1015 synaps, z których każda może występować w wielu stanach. Proste przeliczenia sugerują „pojemność” rzędu terabajtów lub więcej.

Oczywiście nie jest to dysk twardy zapisujący pliki, lecz dynamiczna sieć powiązań. Informacja przechowywana jest nie w pojedynczym neuronie, lecz w wzorcach aktywności i sile połączeń. Równocześnie jednak każdy z tych elementów ma fizyczny nośnik: białka, jony, zmiany strukturalne. Tak jak w pamięci flash przesunięcie elektronów między warstwami wpływa na zapis 0/1, tak w mózgu wymiana cząsteczek fortuje lub osłabia synapsy.

Gdy próbujemy zestawić „wagę” informacji w mózgu z komputerem, kluczowa jest nie tyle ilość bitów, ile sposób ich organizacji i przetwarzania. Niemniej prosty rachunek pokazuje, że każdy ludzki umysł to gigantyczny, niezwykle energooszczędny magazyn danych, którego fizyczna masa mieści się w niewielkiej objętości czaszki.

Energia, ciepło i środowiskowa „masa” informacji

Centra danych jako elektrownie dla bitów

Globalne centra danych zużywają już znaczący ułamek światowej produkcji energii elektrycznej. Każdy przechowywany gigabajt, każde przesłane wideo 4K, każda kopia zapasowa oznaczają konkretne zużycie prądu w serwerowniach, sieciach szkieletowych i urządzeniach końcowych.

Energia ta przekształca się głównie w ciepło. Dlatego wielkie serwerownie wymagają rozbudowanych systemów chłodzenia: od klasycznej klimatyzacji, przez chłodzenie cieczą, aż po lokalizowanie centrów danych w chłodniejszym klimacie. Jednostkowo zapisanie kilku gigabajtów zdjęć w chmurze wydaje się nieważne, natomiast w skali milionów użytkowników przekłada się na realne megawaty mocy ciągle pracujących urządzeń.

Jeśli spojrzeć na informację przez pryzmat równania E = mc², całkowita energia przetwarzana w globalnej infrastrukturze cyfrowej ma swoją efektywną masę. Nie jest to masa „danych” sensu stricto, lecz masa równoważna energii zużywanej i odprowadzanej w postaci ciepła. Matematyka bitów staje się więc częścią większego rachunku ekologicznego.

Minimalizm cyfrowy: porządek w bitach jako praktyka oszczędzania

Zwykłe działania użytkownika mogą realnie wpływać na liczbę utrzymywanych bitów. Kilka przykładów, gdzie porządkowanie informacji ma przełożenie na zużycie zasobów:

- regularne usuwanie niepotrzebnych zdjęć i nagrań z chmury zmniejsza ilość danych kopiowanych między centrami danych,

- czyszczenie skrzynki e‑mail z dużych, wieloletnich załączników redukuje liczbę utrzymywanych kopii na serwerach,

- stosowanie kompresji i formatów o rozsądnym bitrate przy wysyłaniu plików zdejmuje część obciążenia z sieci.

Każda z tych czynności to redukcja liczby bitów, które muszą pozostać w stabilnym stanie na nośnikach, były wielokrotnie kopiowane i zabezpieczane. W skali pojedynczej osoby korzyść nie jest spektakularna, lecz w dużych organizacjach polityka sensownego przechowywania danych potrafi przełożyć się na zmniejszenie zapotrzebowania na dodatkowe serwery czy macierze dyskowe.

Granice miniaturyzacji: jak małe mogą być fizyczne bity

Przez dekady wzrost gęstości zapisu informacji opierał się na zmniejszaniu fizycznych nośników pojedynczych bitów: domen magnetycznych na talerzach dysków czy komórek w pamięciach flash. Dziś rozważa się zapisywanie informacji w skali pojedynczych atomów lub elektronów, co dramatycznie zmniejsza „fizyczną wagę” nośnika na jeden bit.

Napotykane są jednak fundamentalne granice: efekty kwantowe, szumy termiczne i zasada Landauera wyznaczają minimalny koszt energetyczny manipulowania bitami. Zmiana stanu z 0 na 1 w zbyt małym i zbyt gorącym układzie może być nietrwała – przypadkowe fluktuacje termiczne będą zakłócać zapis. Stąd ogromne zainteresowanie nowymi materiałami, niskotemperaturowym chłodzeniem oraz technikami zapisu wykorzystującymi właściwości kwantowe.

Praktycznie oznacza to, że zmniejszanie fizycznej „masy” bitów nie może postępować w nieskończoność bez zmiany samego paradygmatu obliczeń. Wraz z każdym pokoleniem procesorów i pamięci inżynierowie balansują między szybkością, gęstością zapisu, niezawodnością a energią na bit.

Myślenie w bitach jako uniwersalne narzędzie

Od analogowego świata do cyfrowych wyborów

Wiele zjawisk, które sprawiają wrażenie płynnych i analogowych, można opisać jako proces dyskretyzacji do bitów. Mikrofon zamienia ciągłe zmiany ciśnienia powietrza na próbki sygnału; aparat fotograficzny dzieli obraz na piksele i poziomy jasności; czujnik temperatury przesyła do sterownika wartość w postaci liczb zapisanych binarnie.

Świadomość, że za tymi procesami kryją się konkretne liczby bitów, pomaga w podejmowaniu codziennych decyzji technicznych: jaki bitrate ustawić przy nagrywaniu podcastu, jaką rozdzielczość wybrać do prezentacji, czy wykorzystywać zdjęcia RAW, czy wystarczy JPEG. Za każdym razem pytanie brzmi de facto: ile informacji warto zachować, a ile można bezpiecznie pominąć.

Skalowanie intuicji: od pojedynczego pliku do globalnej sieci

Rachunek bitów ma tę zaletę, że łatwo się skaluje. Jeżeli pojedyncze zdjęcie po kompresji ma 2 MB, tysiąc zdjęć to około 2 GB, a milion – około 2 TB. Taka skala pomaga wyobrazić sobie, ile miejsca i energii wymaga komercyjny serwis społecznościowy przyjmujący dziennie miliony nowych fotografii i filmów.

Podobnie z ruchem sieciowym: prosta wideorozmowa zużywająca kilkaset megabajtów na godzinę nie wydaje się znaczącym obciążeniem, ale równoczesne połączenia milionów użytkowników mnożą się w dziesiątki czy setki petabajtów przesyłanych na dobę. Wszystko to to konkretne strumienie bitów, które trzeba gdzieś przesłać, przechować, odtworzyć i ostatecznie skasować zgodnie z fizycznymi ograniczeniami energii i informacji.

Projektowanie decyzji: bity w grach, finansach i medycynie

Modelowanie decyzji również można zapisać w języku bitów i entropii. W teorii informacji niepewność wyników opisuje się liczbą bitów: jeśli mamy cztery jednakowo prawdopodobne scenariusze, potrzeba 2 bitów, by jednoznacznie wskazać, który z nich zaszedł. Dziesięć możliwych diagnoz medycznych, z których część jest bardziej prawdopodobna niż inne, odpowiada pewnej liczbie bitów brakującej wiedzy, którą lekarz redukuje zlecając badania.

Badanie diagnostyczne o wysokiej „mocy informacyjnej” to takie, które silnie zmniejsza niepewność. Test, po którym pozostają w grze dwie hipotezy zamiast dziesięciu, może redukować entropię o kilka bitów. Podobny rachunek można zastosować w systemach rekomendacyjnych, strategiach giełdowych czy projektowaniu ankiet: każde pytanie lub obserwacja ma określony zysk informacyjny, który trzeba zrównoważyć z kosztem jego pozyskania.

W grach komputerowych i hazardowych ta logika jest szczególnie przejrzysta. Rozkład kart w talii, układ pionków na planszy, decyzje o ryzyku – wszystkie te elementy da się analizować jako przepływ informacji między graczem a systemem. Im więcej bitów o stanie gry posiadasz, tym lepsze decyzje możesz podjąć. Z kolei projektant gry ustala, jak szybko i w jaki sposób gracz ma „dokopywać się” do tych bitów, by rozgrywka była ciekawa.

Informacja jako zasób ekonomiczny

We współczesnej gospodarce bity bywają cenniejsze niż fizyczne przedmioty. Dane o zachowaniach klientów, przebiegach maszyn, ruchu w mieście czy przepływach energii są paliwem dla algorytmów podejmujących decyzje w skali, której człowiek nie ogarnąłby ręcznie. Ich wartość można w przybliżeniu wyrazić przez wpływ na zmniejszenie niepewności co do przyszłości rynku, awarii czy popytu.

Im dokładniejsze dane o klientach, tym mniej „niespodzianek” w sprzedaży; im gęstsza sieć czujników w fabryce, tym mniej nieplanowanych przestojów. Formalnie to redukcja entropii stanu systemu. W tle pracuje ten sam rachunek bitów, który opisuje też kompresję plików – tu jednak „algorytmem kompresji” jest model biznesowy i proces decyzyjny.

Przeciętny użytkownik widzi to choćby w dynamicznych cenach biletów lotniczych czy serwisów przewozowych. Każdy dodatkowy bit informacji o popycie, pogodzie, wydarzeniach w mieście i zachowaniu innych klientów pozwala firmie lepiej dopasować cenę do sytuacji. Informacja przekłada się wprost na pieniądze, nawet jeśli jej fizyczna „masa” to tylko śladowa zmiana ładunku w krzemie.

Przyszłość bitów: od klasycznej fizyki do kwantowych informacji

Kubit zamiast bitu: kiedy 0 i 1 są naraz prawdziwe

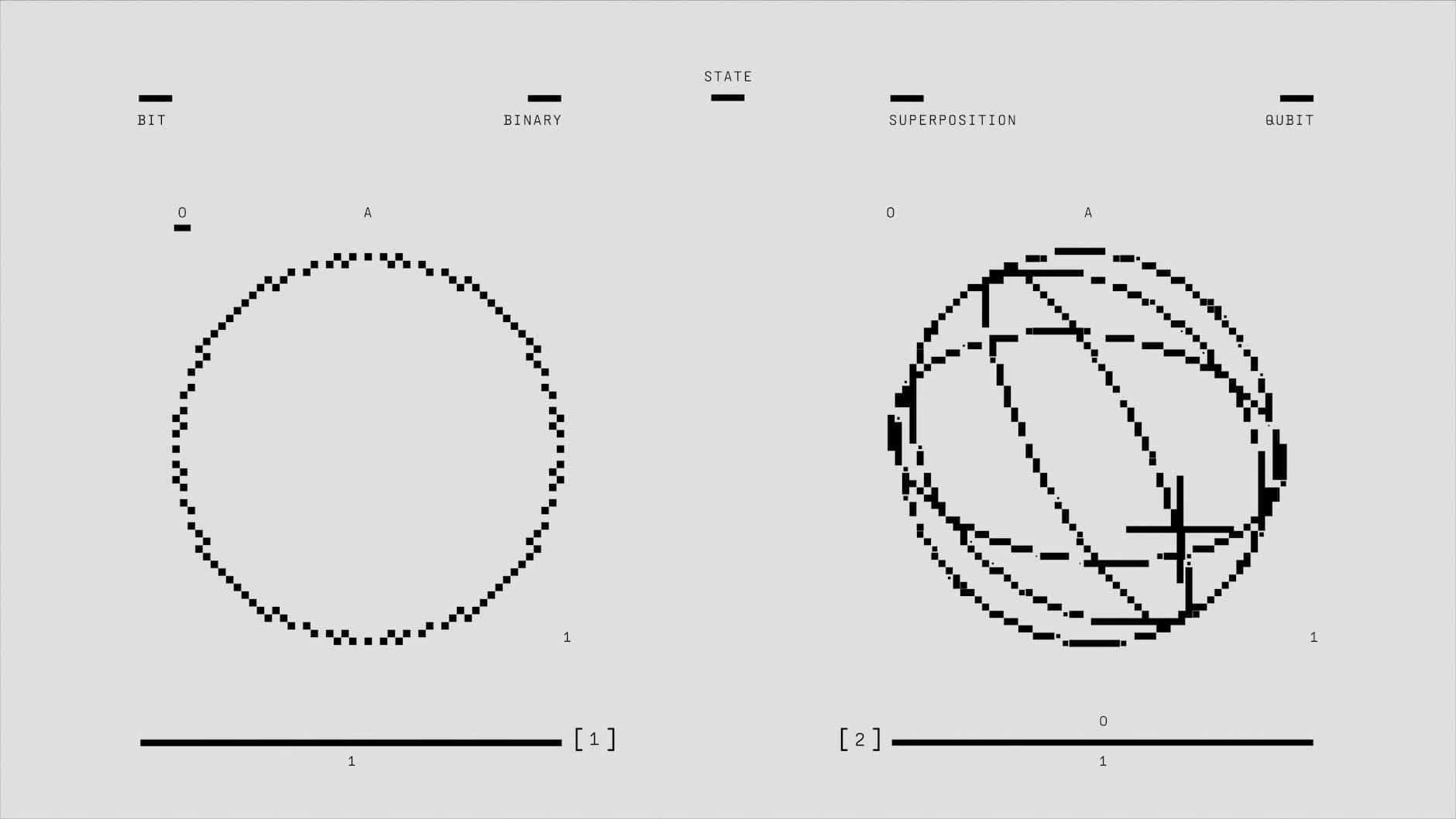

Klasyczny bit może przyjmować wyłącznie wartości 0 lub 1. W komputerze kwantowym podstawową jednostką jest kubit, który może istnieć w superpozycji tych dwóch stanów. Matematycznie opisuje się go jako kombinację │0⟩ i │1⟩ z pewnymi amplitudami, a fizycznie realizuje np. jako stan spinu elektronu, polaryzację fotonu lub poziom energetyczny w pułapce jonowej.

To, co z perspektywy klasycznej przypomina „więcej niż 1 bit” informacji w jednym kubicie, w rzeczywistości jest delikatną strukturą prawdopodobieństw, którą łatwo zniszczyć pomiarem lub szumem. Dopiero zestaw wielu splątanych kubitów daje efekt lawinowego wzrostu przestrzeni stanów – teoretycznie 2n amplitud dla n kubitów. Taki „wykładniczy” zasób jest podstawą przewagi komputerów kwantowych w wybranych zadaniach, jak faktoryzacja czy symulacja układów kwantowych.

Choć kubit nie jest „więcej ważącym bitem”, znów pojawia się pytanie o fizyczną stronę informacji. Stan kwantowy musi być odizolowany od otoczenia, chłodzony często do temperatur bliskich zeru absolutnemu i kontrolowany za pomocą precyzyjnych impulsów. Za każdym kubitem stoją spore ilości energii i skomplikowana infrastruktura, które nadają mu bardzo realny koszt fizyczny.

Entropia kwantowa i granice wiedzy

W świecie kwantowym pojęcie entropii informacji przyjmuje bardziej ogólną postać, zwaną entropią von Neumanna. Zamiast klasycznego rozkładu prawdopodobieństwa mamy macierz gęstości opisującą stan układu. Mimo złożonej matematyki intuicja pozostaje podobna: wyższa entropia to większa niepewność co do wyniku pomiarów, niższa – bardziej uporządkowany stan.

Szczególnie interesujące są sytuacje, w których pojedynczy podukład wydaje się być w stanie o wysokiej entropii, ale cały układ (wraz z otoczeniem) ma entropię niską. W splątaniu kwantowym „brak wiedzy” o części można interpretować jako informację zaszytą w korelacjach z innymi częściami. To kolejny poziom komplikacji w odpowiedzi na pytanie, gdzie właściwie „siedzą” bity opisujące rzeczywistość.

Przy badań nad kwantową grawitacją i czarnymi dziurami łączy się te pojęcia z rozważaniami o powierzchni horyzontu zdarzeń i ilości informacji, jaką może ona pomieścić. Wyniki sugerujące, że maksymalna liczba bitów zależy od pola powierzchni, a nie objętości, prowadzą do radykalnie holograficznego spojrzenia na wszechświat – jakby fundamentalne bity były zapisane na „brzegach” przestrzeni, a to, co widzimy wewnątrz, było tylko ich rozwinięciem.

Codzienna praktyka: jak używać matematyki bitów w życiu

Szacowanie rozmiarów i czasów: ile to się będzie wysyłać

Prosta umiejętność przeliczania bitów i bajtów pozwala planować zwykłe czynności techniczne bez zgadywania. Przydatnych kilka reguł kciuka:

- 8 bitów to 1 bajt; 1 MB to w przybliżeniu milion bajtów, 1 GB – miliard,

- łącza internetowe podawane są najczęściej w megabitach na sekundę (Mb/s), a pliki w megabajtach (MB) – 10 MB to około 80 Mb,

- czas pobierania pliku można oszacować dzieląc jego rozmiar (w megabitach) przez realną przepustowość łącza.

Jeśli telefon pokazuje, że film ma 1,5 GB, a domowe łącze oferuje realnie 50 Mb/s, to: 1,5 GB ≈ 12 000 Mb, 12 000 / 50 daje około 240 sekund, czyli cztery minuty pobierania. Tego typu szacunek można wykonać „w głowie”, wiedząc, jak przeliczać jednostki. To wciąż ten sam rachunek na bitach, tylko podany w bardziej praktycznej formie.

Podobnie można ocenić, ile miejsca zajmą codzienne kopie zapasowe, strumień monitoringu z kamer czy paczka logów z aplikacji w chmurze. Nawet przy bardzo przybliżonych danych porządek wielkości – megabajty kontra gigabajty – często wystarcza, by podjąć sensowną decyzję o konfiguracji systemu czy zakupie nośników.

Zarządzanie prywatnością jako redukcja zbędnych bitów

Informacja, którą ujawniasz innym, ma wymiar nie tylko społeczny, lecz także ilościowy. Każde dodatkowe pole w formularzu, każdy zgromadzony log o twojej aktywności, to kolejne bity opisujące twoją osobę. Z perspektywy prywatności rozsądne jest ograniczanie liczby zbieranych i przechowywanych bitów do tych, które faktycznie są potrzebne.

Tu również przydaje się prosta intuicja informacyjna. Zamiast podawać pełną datę urodzenia, wystarczy zakres wieku; zamiast dokładnego adresu – dzielnica; zamiast surowych nagrań audio – ich zagregowane statystyki. Każde takie przybliżenie zmniejsza ilość bitów, z których ktoś mógłby odtworzyć szczegółowy profil. To nie jest zero-jedynkowe „daję dane lub nie”, lecz świadome sterowanie precyzją, czyli liczbą bitów informacji o sobie.

Firmy wdrażające zasady minimalizacji danych robią podobny rachunek, tylko na większą skalę. Mniej trwale gromadzonych bitów to mniejsze ryzyko wycieku, niższe koszty zgodności z regulacjami oraz prostsza infrastruktura. Zamiast zbierać „na wszelki wypadek”, projektuje się systemy tak, by każdy bit miał uzasadnienie.

Uczenie, zapominanie i selekcja informacji

Każdego dnia do naszego mózgu dociera więcej bitów, niż jesteśmy w stanie trwale przechować. Mechanizmy uwagi, filtracji i zapominania można rozumieć jako swoistą kompresję treści do ograniczonego budżetu pamięci. Silne skojarzenia, emocje i powtórzenia zwiększają „priorytet” danej porcji informacji, dzięki czemu zyskuje ona trwalszy ślad w sieci neuronów.

W tej perspektywie kluczowe umiejętności poznawcze – koncentracja, selekcja źródeł, krytyczne myślenie – stają się czymś w rodzaju algorytmu zarządzania bitami. Zamiast chłonąć każdy bodziec, sensowniej jest świadomie wybierać, które strumienie informacji otrzymują przepustkę do pamięci długotrwałej, a które pozostaną jedynie krótkim „szumem” w buforze uwagi.

Zastosowanie prostego filtra – ograniczenie powiadomień, kuracja subskrypcji, okresowe „sprzątanie” źródeł treści – można porównać do optymalizacji systemu plików. Redukujesz ilość nieistotnych bitów, dzięki czemu te ważne są łatwiejsze do odnalezienia i mniej konkurują o zasoby, jakimi są czas i energia poznawcza.

Informacja jako część fizycznego świata

Kiedy bity zmieniają rzeczywistość materialną

Wielu zjawisk nie da się już rozdzielić na „cyfrowe” i „fizyczne”. Program sterujący drukarką 3D to nic innego jak uporządkowany ciąg bitów, który przekłada się na ruchy głowicy i wytworzenie konkretnego obiektu. Schemat domowej automatyki decyduje, kiedy włączy się ogrzewanie, a dane z czujników pogodowych sterują pracą elektrowni wiatrowych i fotowoltaicznych.

Na tym poziomie informacja przestaje być abstrakcją. Każda zmiana konfiguracji bitów w systemie sterowania to inny przebieg procesu fizycznego: inne zużycie energii, inne zużycie materiału, inny komfort użytkownika. Projektant takich systemów de facto „rzeźbi” w bitach, których konsekwencją są obserwowalne zmiany w świecie materialnym.

Przykładowo, aktualizacja oprogramowania w samochodzie może zmienić sposób pracy skrzyni biegów czy systemu wspomagania kierowcy, bez wymiany jakiejkolwiek części. Zmieniły się jedynie bity w pamięci sterowników; ich nowy układ prowadzi jednak do innych sygnałów wysyłanych do wykonawczych podzespołów. Fizyczny ślad decyzji zapisanych w bitach pojawia się na drodze – w zużyciu paliwa, emisji spalin czy czasie reakcji na awaryjne hamowanie.

Informacja, chaos i porządek

W ujęciu termodynamicznym entropia bywa utożsamiana z nieuporządkowaniem. Teoria informacji odwraca perspektywę: wysoka entropia to bogactwo możliwych stanów, a informacja pojawia się, gdy wybieramy jeden z nich. W codziennych sytuacjach te dwa opisy często spotykają się w zaskakujący sposób.

Rozważ fizyczne biurko zasypane dokumentami. Z punktu widzenia entropii jest ono w stanie wysokiego nieuporządkowania: trudno od razu znaleźć konkretny arkusz. Po uporządkowaniu stosów liczba „równouprawnionych” stanów maleje, a informacja o tym, gdzie leży dany dokument, staje się łatwiej dostępna. To nie tylko metafora – katalogi, etykiety i systemy numeracji przyporządkowują dokumentom kody, czyli konkretne sekwencje bitów, które redukują niepewność co do ich położenia.

Cyfrowe porządkowanie danych działa analogicznie. Dobrze zaprojektowana struktura folderów, system tagów czy nazewnictwo plików zmniejszają „informacyjną entropię” twojego dysku. Dokładasz pracy przy nadawaniu każdej porcji informacji czytelnych metadanych, za to później oszczędzasz czas i energię przy jej odnajdywaniu. Rachunek bitów pojawia się tu w najbardziej praktycznym wymiarze – jako narzędzie do ujarzmiania rosnących zasobów treści.

Najczęściej zadawane pytania (FAQ)

Czy informacja naprawdę ma wagę w sensie fizycznym?

Tak, ale jest to waga tak mała, że w praktyce niemożliwa do zmierzenia zwykłymi metodami. Zmiana stanu fizycznego nośnika informacji (np. orientacji magnetycznej na dysku lub ładunku w pamięci flash) wiąże się ze zmianą energii, a zgodnie z równaniem Einsteina E = mc² każdej energii można przypisać równoważną masę.

W efekcie dodanie lub skasowanie danych na współczesnym nośniku zmienia jego masę o wartości rzędu znacznie mniejszym niż masa pojedynczej cząsteczki. Z punktu widzenia użytkownika dysk lub telefon waży tyle samo, niezależnie od zapełnienia danymi.

Czy skasowanie plików z dysku sprawia, że komputer jest lżejszy?

W praktyce nie. Różnice masy wynikające z kasowania lub zapisywania informacji są tak absurdalnie małe, że nie ma szans ich zmierzyć nawet bardzo czułą wagą laboratoryjną. Masę komputera determinują głównie materiały: obudowa, elektronika, bateria, chłodzenie, a nie stan zapisanych bitów.

Kasowanie plików ma jednak realny „koszt” energetyczny: generuje ciepło i zużywa energię elektryczną. To ten aspekt jest istotny dla inżynierów i fizyków, a nie mikroskopijna zmiana masy nośnika.

Ile waży 1 bit informacji?

Teoretyczna równoważna masa pojedynczego bitu zależy od energii potrzebnej do zmiany lub usunięcia tego bitu. Zasada Landauera mówi, że minimalna energia rozproszenia przy skasowaniu jednego bitu wynosi kT ln 2 (gdzie k to stała Boltzmanna, a T to temperatura w kelwinach). Gdy tę energię podstawimy do E = mc², otrzymujemy ekstremalnie małą masę – wiele rzędów wielkości mniejszą niż masa protonu.

W języku praktycznym można więc powiedzieć: „bit ma wagę”, ale jest ona tak mała, że poza rozważaniami teoretycznymi i projektowaniem skrajnie energooszczędnych układów nie ma wpływu na codzienne życie.

Czy SMS waży mniej niż film HD?

Jeśli mówimy o „wadze cyfrowej”, czyli rozmiarze danych, to tak – SMS to zwykle kilobajty, a film HD to od setek megabajtów do kilku gigabajtów, czyli miliony razy więcej informacji. Taki film zajmuje więc więcej miejsca na dysku, wymaga szerszego łącza do przesłania i większych zasobów do przechowywania.

W sensie fizycznym oba zapisy na tym samym nośniku różnią się masą jedynie o mikroskopijną wartość odpowiadającą różnicy energii zapisanych stanów. Technicznie film HD „waży” więcej niż SMS, ale jest to różnica całkowicie pomijalna wobec masy samego urządzenia.

Co to jest bit i czym różni się od bajta?

Bit (b) to najmniejsza jednostka informacji, która może przyjąć jedną z dwóch wartości: 0 albo 1. Z punktu widzenia teorii informacji odpowiada to rozstrzygnięciu pytania typu „tak/nie”, przy założeniu, że oba wyniki są równie prawdopodobne.

Bajt (B) to zwykle 8 bitów. Taka paczka bitów może zapisać 2⁸ = 256 różnych stanów, co wystarcza np. do zakodowania pojedynczego znaku w standardowym tekście. W praktyce pojemność pamięci podaje się właśnie w bajtach (KB, MB, GB), a prędkość łącza internetowego – w bitach na sekundę (Mb/s).

Jak logarytm dwójkowy wiąże się z ilością informacji?

W teorii informacji ilość informacji przypisana jednemu wynikowi o prawdopodobieństwie p opisuje wzór I = −log₂(p). Logarytm dwójkowy sprawia, że jednostką naturalną jest bit: zdarzenie o prawdopodobieństwie 1/2 niesie 1 bit informacji, 1/4 – 2 bity itd. Dzięki temu można porównywać „informacyjność” różnych zdarzeń i wiadomości w tej samej skali.

Gdy mamy N jednakowo prawdopodobnych wyników, pojedyncze rozstrzygnięcie niesie log₂(N) bitów informacji. To tłumaczy m.in., dlaczego 1 bajt (8 bitów) może reprezentować 256 (2⁸) różnych znaków czy stanów.

Na czym polega zasada Landauera i jaki ma związek z kasowaniem danych?

Zasada Landauera mówi, że usunięcie jednego bitu informacji wymaga wydzielenia co najmniej kT ln 2 energii w postaci ciepła. Innymi słowy: „zapominanie” informacji w układzie fizycznym nigdy nie jest całkowicie darmowe energetycznie, nawet w idealnie sprawnym komputerze.

Współczesne urządzenia zużywają przy kasowaniu danych wielokrotnie więcej energii niż to minimalne teoretyczne minimum, ale ta zasada wyznacza absolutną granicę efektywności. To ona łączy abstrakcyjną informację z bardzo konkretną fizyką: temperaturą, energią, entropią, a pośrednio również z masą poprzez relację E = mc².

Najważniejsze lekcje

- Informacja, choć jest pojęciem abstrakcyjnym, ma bardzo konkretne znaczenie praktyczne: zajmuje miejsce w pamięci, wymaga energii do przetwarzania i w mikroskali wpływa na fizyczne właściwości nośników.

- Bit (0 lub 1) to podstawowa jednostka informacji, odpowiadająca rozstrzygnięciu pytania „tak/nie”; wszystko, co cyfrowe – tekst, zdjęcia, filmy – da się zapisać jako długie sekwencje bitów.

- Ilość informacji zależy od prawdopodobieństwa zdarzenia: im rzadsze zdarzenie (niższe p), tym więcej informacji niesie jego wystąpienie, co opisuje wzór Shannona I = −log₂(p) w bitach.

- Jeśli mamy N jednakowo prawdopodobnych stanów, pojedyncze rozstrzygnięcie dostarcza log₂(N) bitów informacji – stąd np. 1 bajt (8 bitów) może kodować 256 różnych znaków.

- W praktyce zamiast pojedynczych bitów używa się większych jednostek (B, KB, MB, GB, TB), a kluczowe jest rozróżnienie między b (bit) i B (bajt), bo różnica to czynnik 8 i ma znaczenie przy pojemności i szybkości łączy.

- Matematyka bitów jest logarytmiczna: każdy dodatkowy bit podwaja liczbę możliwych stanów, co pozwala bardzo precyzyjnie odwzorowywać złożone obiekty, ale kosztem rosnących wymagań na miejsce i energię.

- Aby informacja „istniała” w świecie fizycznym, musi być zapisana na konkretnym nośniku (np. dysk, pamięć flash, płyta), a operacje zapisu i kasowania danych wiążą się z realnymi, choć mikroskopijnymi, zmianami energii i masy.